Das Leibniz-Rechenzentrum der Bayerischen Akademie der Wissenschaften in Garching erhält im Sommer diesen Jahres den weltweit größten und leistungsfähigsten Superchip für Künstliche Intelligenz (KI). Damit können die bayerischen Spitzenforscher künftig mit der höchsten, zurzeit erzielbaren Rechenleistung für KI arbeiten. Im Fokus der Forscher stehen Spitzenprojekte in den Bereichen Sprachverarbeitung (Natural Language Processing), medizinische Diagnostik, (Wetter-)Vorhersagen und Strömungsberechnungen etwa in der Luftfahrtentwicklung und der industriellen Herstellung.

Gigantische Leistungdaten

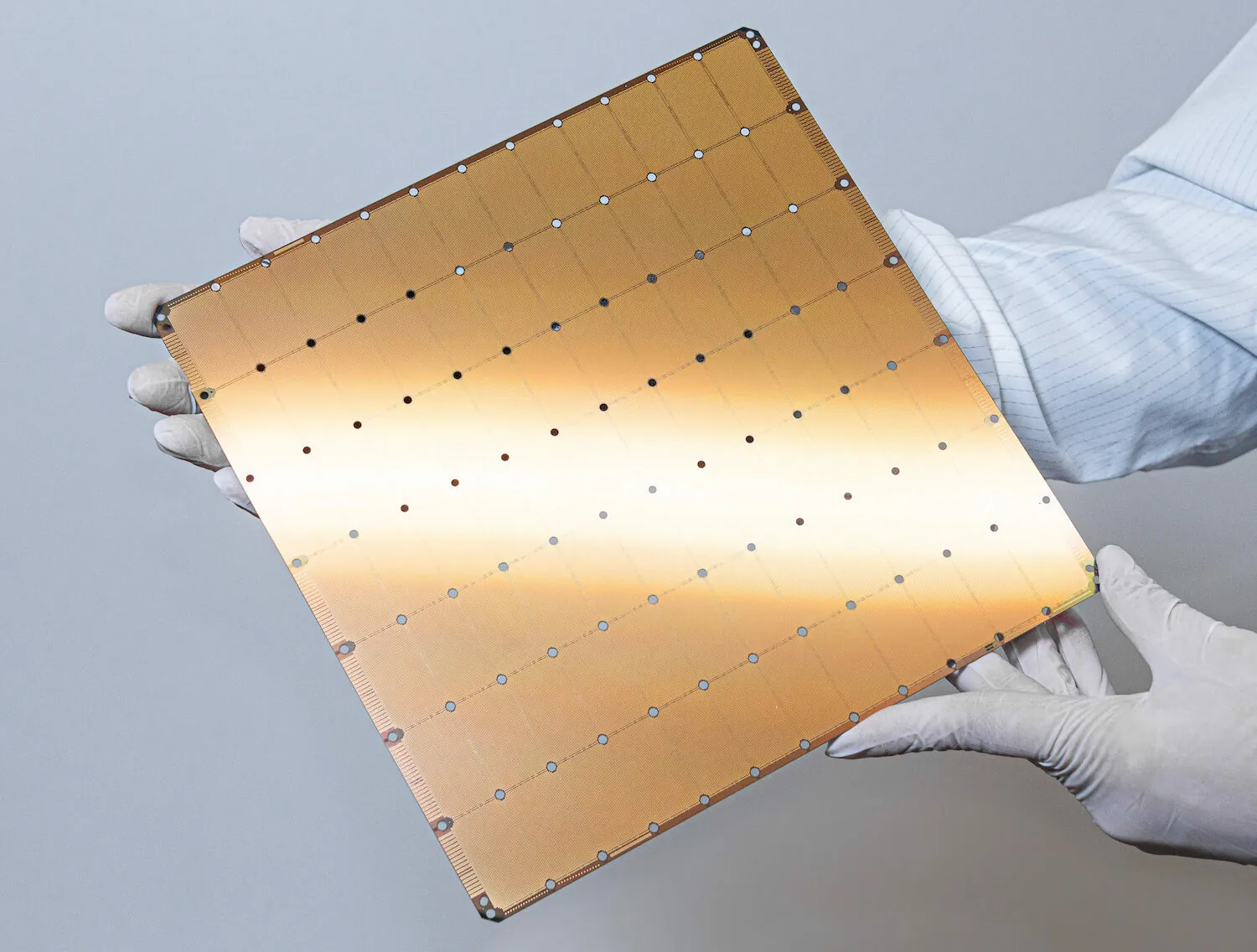

Die sogenannte Wafer Scale Engine 2 (WSE2) des Chipherstellers Cerebras ist etwa so groß wie ein Essteller und damit 54 Mal größer als der zweitplatzierte Konkurrent. Schon das sind Dimensionen, die man von Computerchips normalerweise nicht gewohnt ist. Noch beeindruckender sind die Leistungsdaten des Superchips: Auf insgesamt 46.225 Quadratmillimetern arbeiten 2,6 Billionen Transistoren und 850.000 auf KI spezialisierte Rechenkerne sozusagen „Hand in Hand“. Rasend schnell: Bis zu 220 Petabit pro Sekunde (220 Milliarden Megabit) sollen die Datenleitungen auf dem Chip transportieren können.

Das macht den Superchip von Cerebras besonders für tief gestaffelte, selbst lernende Neuronale Netze interessant (sogenanntes Deep Learning). Neuronale Netze, die leistungsfähigste Avantgarde-Technologie der KI, gelten als besonders rechenintensiv. In der Trainingsphase müssen Milliarden Optionen durchgespielt und evaluiert werden, bis das Neuronale Netz einsatzbereit ist und optimale Ergebnisse liefert. Und die Trainingsphase hört niemals auf, das Neuronale Netz lernt ständig Neues dazu. Neuronale Netze sind sehr leistungsfähig, „fressen“ aber auch extrem viel Rechenpower.

„Derzeit beobachten wir, dass sich der Rechenbedarf an KI-Rechnern bei unseren Nutzern alle drei bis vier Monate verdoppelt. Durch die hohe Integration von Prozessoren, Speicher und On-Board-Netzwerken auf einem einzigen Chip ermöglicht Cerebras eine hohe Leistung und Geschwindigkeit. Das verspricht deutlich mehr Effizienz in der Datenverarbeitung und damit einen schnelleren Durchbruch bei wissenschaftlichen Erkenntnissen“, sagt Professor Dieter Kranzlmüller, Direktor des Leibniz-Rechenzentrums (LRZ).

Zukunft: Komplexe KI-Rechenpower einfach „as a Service“

Seine Kollegin Laura Schulz, Head of Strategy am LRZ, wirft einen Blick in die Zukunft: „Computing wird immer komplexer, die Systeme werden heterogener und auf spezifische Anwendungen abgestimmt. Wir sollten aufhören, in High-Performance-Computing- oder KI-Systemen zu denken. Wir arbeiten auf eine Zukunft hin, in der die zugrundeliegende Rechenleistung komplex ist, aber den Nutzer so wenig wie möglich beeinträchtigt“.