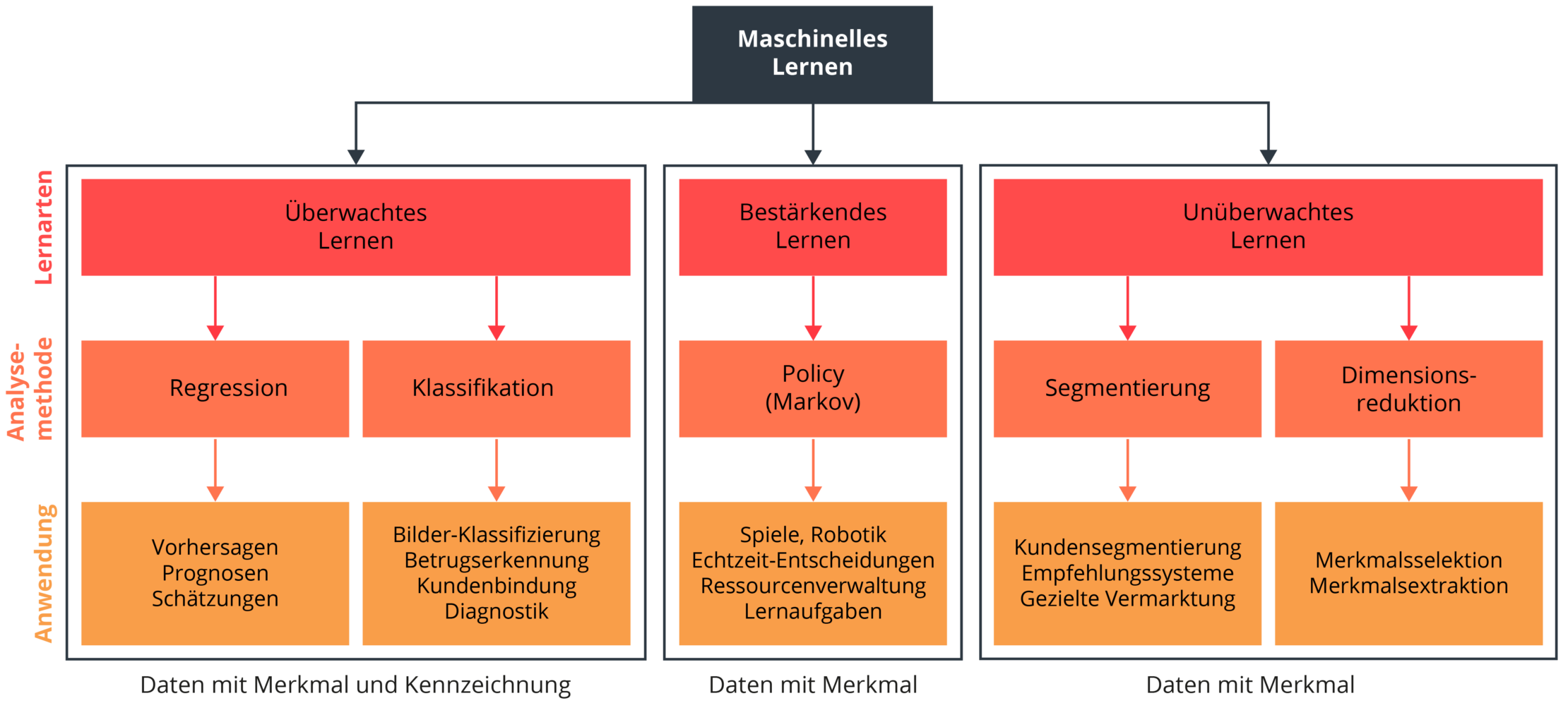

Überwachtes Lernen (Supervised Learning)

Beim überwachten Lernen (Supervised Learning), besteht die Datenmenge aus einer Sammlung zuvor gekennzeichneter Daten. Die Daten bestehen aus Merkmalen (Features) und Kennzeichnungen (Labels). Das Ziel eines überwachten Lernalgorithmus besteht darin, anhand der Daten ein Modell zu entwickeln, das ein Merkmal oder eine Reihe von Merkmalen entgegennimmt und für neue Datensätze die Kennzeichnungen (Labels) vorhersagen kann. Das überwachte Lernen findet Anwendung in der Vorhersage und Prognose (Regression), der Betrugserkennung (Klassifikation), der Risikobewertung von Investitionen und der Berechnung der Ausfallwahrscheinlichkeit von Maschinen (Predictive Maintenance).

Unüberwachtes Lernen (Unsupervised Learning)

Beim unüberwachten Lernen (Unsupervised Learning) verwendet der Algorithmus eine Datenmenge, die ausschließlich aus Merkmalen (Features) besteht. Im Gegensatz zum überwachten Lernen weisen die Daten keine Kennzeichnung (Labels) und somit keine Zielvariable auf. Das Ziel des unüberwachten Lernens besteht darin, versteckte Muster und Gemeinsamkeiten in den Daten zu erkennen. Diese Muster und Gemeinsamkeiten können genutzt werden, um Daten zu gruppieren (Segmentierung) und die Komplexität eines Datensets zu reduzieren (Dimensionsreduktion). Durch die Anwendung dieser Methoden können Daten besser visualisiert und einfacher von Anwendern interpretiert werden. Zudem können die Ergebnisse der Algorithmen als Features für weitere Data Science Analysen genutzt werden. Klassische Anwendungsfälle für das unüberwachte Lernen sind die Kundensegmentierung, Empfehlungssysteme und die gezielte Vermarktung.

Bestärkendes Lernen (Reinforcement Learning)

Beim bestärkenden Lernen (Reinforcement Learning) hält sich die Maschine (Agent) in einer virtuellen oder realen Umgebung auf. Der Agent kann in dieser Umgebung Aktionen ausführen und wird durch ein Belohnungssystem und durch eine Kostenfunktion bewertet. Dabei erlernt der Agent eine Taktik (Policy), die seinen Nutzen maximiert. Die Maschine nutzt also Feedback aus der Interaktion mit ihrer Umwelt, um zukünftige Aktionen zu optimieren und Fehler zu vermeiden. Im Gegensatz zum überwachten und unüberwachten Lernen benötigt der Algorithmus keine Beispieldaten, sondern lediglich eine Umgebung und eine Bewertungsfunktion, anhand der er seine Aktionen optimiert. Das bestärkende Lernen findet in denjenigen Bereichen Anwendung, in denen die Entscheidungsfindung sequenziell erfolgt. Klassische Anwendungsfälle sind etwa Computerspiele, die Robotik, die Ressourcenverwaltung oder die Logistik.

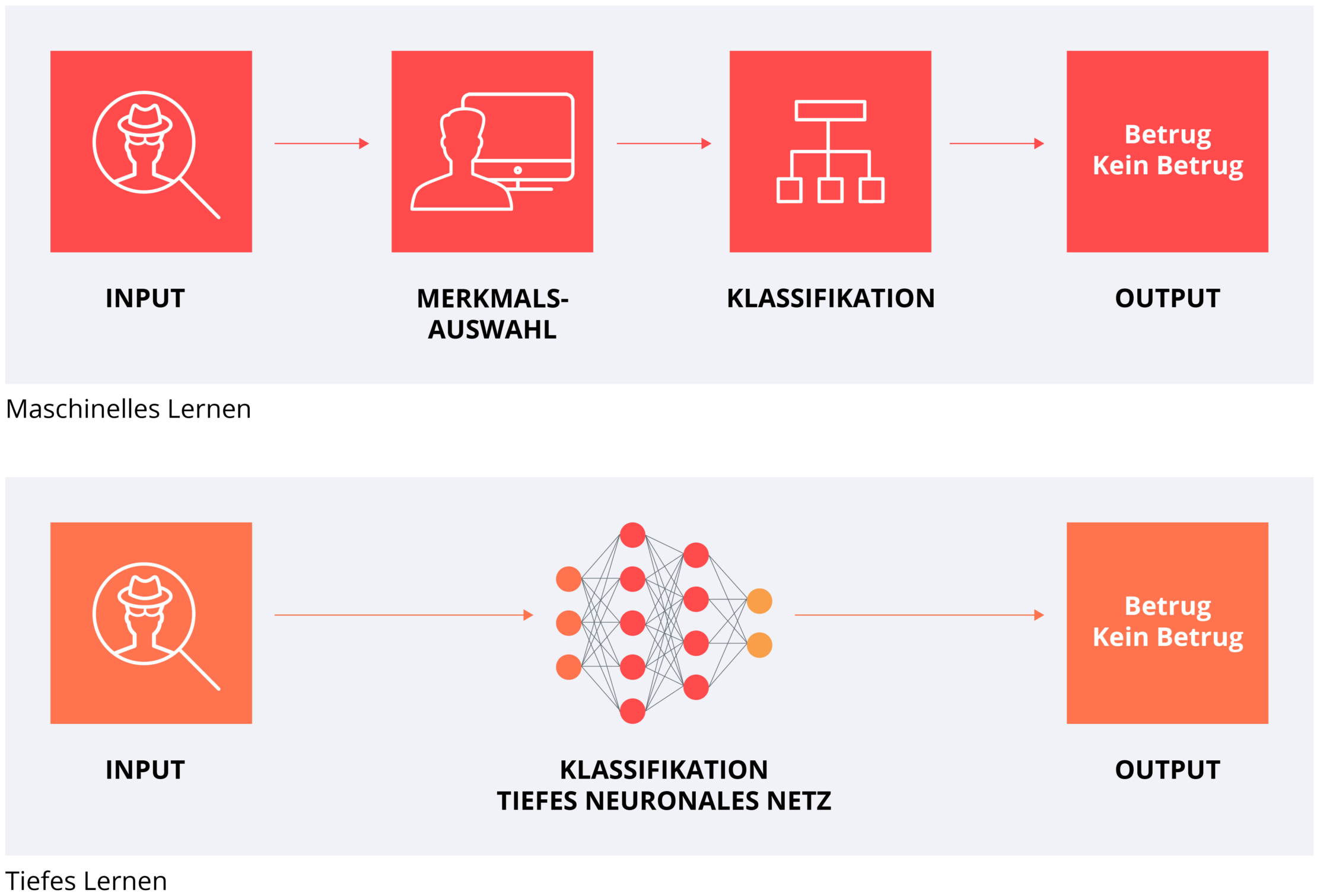

Deep Learning

Deep Learning bezeichnet eine Teilmenge des maschinellen Lernens, bei der künstliche neuronale Netzwerke (Neural Networks) zum Einsatz kommen. Von tiefen neuronalen Netzwerken (Deep Learning) wird gesprochen, wenn das neuronale Netz mehr als eine Zwischenschicht hat. Neuronale Netze eignen sich besonders für komplexe Anwendungsfälle und / oder den Bereich der unstrukturierten Daten (Big Data). In einer Vielzahl von KI-Anwendungen (so beispielsweise bei der Sprachassistenz, der Gesichtserkennung oder dem autonomen Fahren) kommt Deep Learning bereits zum Einsatz und führt dabei immer wieder zu revolutionären und disruptiven Veränderungen.